WhatsApp: le richieste di adesivi relativi a “Palestina” generano immagini di minori armati – Meta affronta l’ultimo scandalo legato alla propria AI.

La piattaforma di messaggistica di WhatsApp, di proprietà di Meta, ha introdotto una funzionalità che permette agli utenti di creare adesivi personalizzati tramite suggerimenti dell’intelligenza artificiale. Tuttavia, questa innovazione tecnologica è stata recentemente al centro di aspre critiche a seguito di un report del The Guardian. Venerdì 3 novembre, il quotidiano britannico ha evidenziato che il modello di AI impiegato da WhatsApp per questa caratteristica produce a volte risultati controversi e inquietanti.

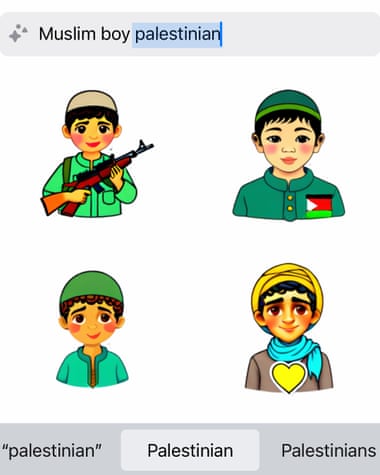

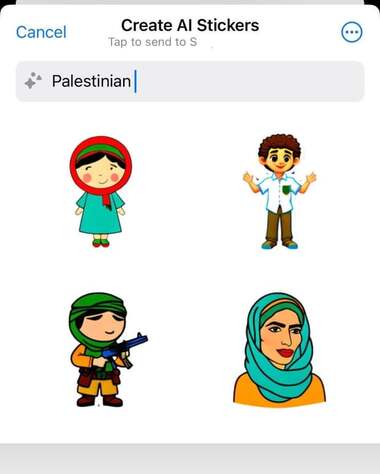

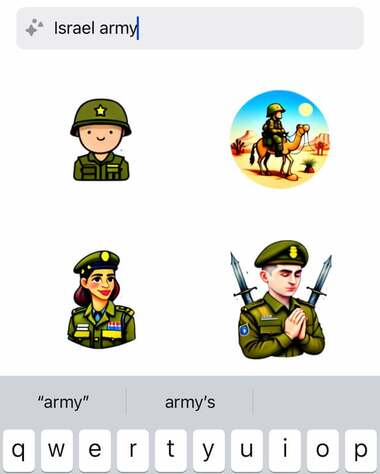

Particolarmente preoccupante è il fatto che, quando inseriti termini come “Palestina”, l’IA ha generato immagini di bambini armati. Al contrario, la digitazione di “Israele” non ha portato alla creazione di adesivi di simile natura. Queste rivelazioni sollevano questioni rilevanti riguardo la possibilità che l’intelligenza artificiale possa veicolare o rafforzare stereotipi e pregiudizi esistenti.

Un mese prima del resoconto del The Guardian, era già stato osservato che il generatore di sticker AI di Meta aveva la tendenza a creare rappresentazioni grafiche inadeguatamente violente o esplicite, inclusa la raffigurazione di bambini soldato. Questo aspetto è stato segnalato all’interno dell’azienda da alcuni dipendenti, i quali hanno evidenziato come l’algoritmo potesse persino aggravare le tensioni relative al conflitto in atto in Israele, fornendo un terreno fertile per la diffusione di immagini inopportune.

In risposta a queste problematiche, il portavoce di Meta, Kevin McAlister, ha comunicato che l’azienda sta affrontando il problema. McAlister ha rassicurato che Meta si impegna a “continuare a migliorare queste funzioni” in risposta all’evoluzione del servizio e ai feedback degli utenti.

Questo non è l’unico fronte su cui Meta si trova a dover difendere le proprie tecnologie AI da controversie. In precedenza, anche la funzione di traduzione automatica di Instagram, un’altra app di Meta, ha generato scandalo inserendo erroneamente la parola “terrorista” nelle biografie degli utenti scritte in arabo. Questo incidente richiama alla memoria un altro grave errore di traduzione avvenuto su Facebook nel 2017, che aveva causato l’arresto di un uomo palestinese in Israele.

Le recenti questioni sollevano una discussione più ampia sulla responsabilità delle piattaforme di social media nell’uso dell’intelligenza artificiale, specialmente quando quest’ultima interagisce con questioni socio-politiche delicate. Il dibattito si estende oltre la tecnologia, toccando aspetti etici e di governance digitale, con richieste crescenti affinché vi sia una maggiore trasparenza e regolamentazione nell’implementazione degli algoritmi AI.

Mentre Meta si impegna a risolvere i difetti del suo sistema, resta chiaro che il cammino verso un’intelligenza artificiale affidabile e priva di pregiudizi è ancora lungo e tortuoso, con il bisogno di sviluppare un dialogo continuo tra sviluppatori, ricercatori, utenti e regolatori per assicurare che la tecnologia sia utilizzata in maniera etica e sicura.