La generazione da testo a immagine è il processo algoritmico più in voga del momento, con Craiyon di OpenAI e Imagen AI di Google che hanno scatenato ondate di arte procedurale sintetizzata da immaginazione umana e informatica. Alcuni giorni fa Meta ha rivelato di aver sviluppato un motore di generazione di immagini AI che spera possa aiutare a costruire mondi immersivi nel Metaverso e a creare arte digitale di alto livello. Make-a-Scene è il nome del progetto di intelligenza artificiale sviluppata da Meta.

La creazione di un’immagine basata sull’elaborazione di una frase richiede molto lavoro quando si utilizza un motore di generazione di immagini. Per prima cosa la frase stessa viene fatta passare attraverso un modello trasformatore, una rete neurale che analizza le parole della frase e sviluppa una comprensione contestuale della loro relazione reciproca. Una volta capito il senso di ciò che l’utente sta descrivendo, l’IA sintetizza una nuova immagine utilizzando una serie di GAN (generative adversarial networks).

Grazie agli sforzi compiuti negli ultimi anni per addestrare i modelli di ML su insiemi di immagini sempre più ampi e ad alta definizione con descrizioni testuali ben curate, le IA di ultima generazione sono oggi in grado di creare immagini fotorealistiche praticamente di qualsiasi cosa, anche le più strane. Il processo di creazione specifico varia da un’IA all’altra.

Per esempio, Imagen di Google utilizza un modello che impara a convertire uno schema di punti casuali in immagini. L’AI Parti di Google segue un iter diverso convertendo una serie di immagini in una sequenza di codice, poi un messaggio di testo viene tradotto in questo codice e viene creata una nuova immagine.

Sebbene questi sistemi possano creare quasi tutto ciò che viene loro descritto, l’utente non ha alcun controllo sugli aspetti specifici dell’immagine in uscita. “Per realizzare il potenziale dell’IA di far progredire l’espressione creativa“, ha dichiarato Mark Zuckerberg, CEO di Meta, “le persone dovrebbero essere in grado di modellare e controllare i contenuti generati dal sistema“.

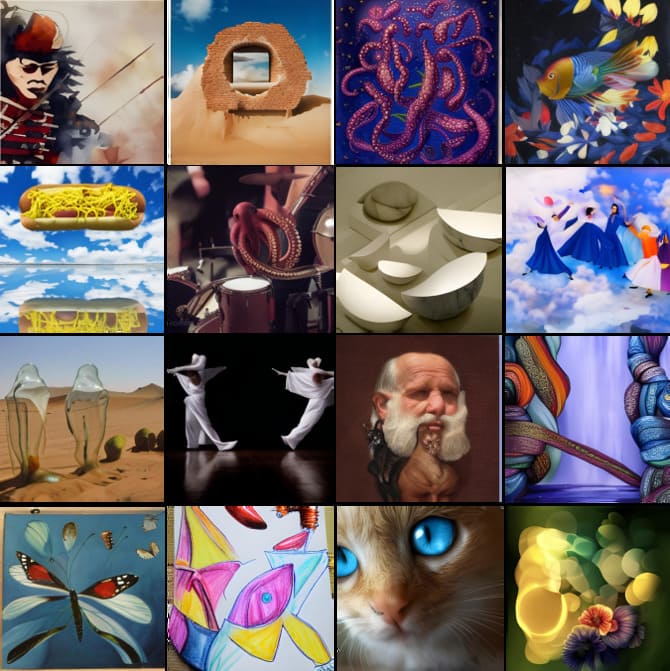

Make-A-Scene fa proprio questo incorporando gli schizzi creati dall’utente alla generazione di immagini basate sul testo, producendo un’immagine di 2.048 x 2.048 pixel. Questa combinazione consente all’utente non solo di descrivere ciò che desidera nell’immagine, ma anche di dettare la composizione complessiva dell’immagine. “Dimostra come le persone possano utilizzare sia il testo che semplici disegni per trasmettere la loro visione con maggiore specificità, utilizzando una varietà di elementi, forme, disposizioni, profondità, composizioni e strutture“, ha dichiarato Zuckerberg.

Nei test, un gruppo di valutatori umani ha scelto in modo schiacciante l’immagine con testo e disegno rispetto a quella con solo testo, in quanto meglio allineata con lo schizzo originale (99,54% delle volte) e meglio allineata con la descrizione del testo originale il 66% delle volte. Per sviluppare ulteriormente la tecnologia, Meta ha condiviso la demo di Make-A-Scene con artisti AI di spicco, tra cui Sofia Crespo, Scott Eaton, Alexander Reben e Refik Anadol, che utilizzeranno il sistema e forniranno un feedback. Non si sa ancora quando l’IA sarà resa disponibile al pubblico.